L'intelligence artificielle ne cesse de repousser les limites de l'impossible, et avec elle, les inquiétudes grandissent. Alors que les outils comme ChatGPT s'infiltrent dans nos écoles, nos bureaux et nos loisirs, Sam Altman, le patron d'OpenAI, a tiré la sonnette d'alarme lors du récent sommet à New Delhi. Pour la génération 16-25 ans, cette prise de position n'est pas anecdotique : elle dessine l'avenir d'une technologie qui façonne déjà leur quotidien numérique. Mais derrière ce plaidoyer pour la sécurité se cache une bataille complexe entre innovation, protection de la jeunesse et intérêts commerciaux géants.

L'appel à l'aide du patron d'OpenAI

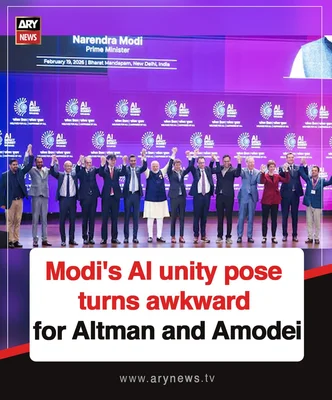

Lors du sommet IA Impact Summit qui s'est tenu à New Delhi en février 2026, Sam Altman ne s'est pas contenté de vanter les mérites de ses technologies. Le PDG d'OpenAI a déclaré devant un parterre de dirigeants mondiaux que le monde avait besoin « d'urgence » de règles pour encadrer l'intelligence artificielle. Sa citation est sans équivoque : il ne suggère pas que l'IA doit rester libre de toute contrainte, mais qu'elle exige un cadre strict, similaire à celui qui existe pour d'autres technologies puissantes comme l'énergie nucléaire.

Une nécessité internationale comparée au nucléaire

Cet appel fait écho aux propos tenus par de nombreux dirigeants politiques présents en Inde, dont Emmanuel Macron, qui a insisté sur la nécessité de protéger les enfants des « violences numériques ». Le contexte politique tendu, marqué par des dérives comme la création de deepfakes sexualisés via le chatbot Grok d'Elon Musk, donne une résonance particulière à ces déclarations. Altman a même proposé la création d'une structure internationale, comparable à l'AIEA (Agence internationale de l'énergie atomique), pour superviser le développement de ces super-intelligences. Pour les jeunes utilisateurs qui grandissent avec ces outils, l'enjeu est de savoir si cette régulation sera un bouclier efficace ou une simple déclaration d'intention.

La vision à mille milliards et l'impératif de confiance

Ce plaidoyer public intervient alors qu'OpenAI traverse une phase de transformations internes majeures. L'entreprise restructure ses opérations pour poursuivre une vision à mille milliards de dollars, cherchant à déployer des infrastructures massives pour soutenir une demande exponentielle. Pourtant, ce déploiement effréné se heurte à la réalité des risques sociétaux. Altman semble avoir compris que sans confiance publique, il n'y a pas d'adoption massive, et par conséquent, pas de rentabilité à long terme. Mais comment passer des discours aux actes ?

La proximité de la superintelligence

Le patron d'OpenAI ne se contente pas de vagues promesses. Il prédit que nous pourrions être à quelques années seulement de la « vraie superintelligence ». Dès 2028, selon lui, l'intelligence présente dans les centres de données pourrait surpasser celle de l'humanité entière. Cette prospective vertigineuse justifie, selon lui, une mise en place immédiate de garde-fous. L'idée est de prévenir le pire scénario avant que la machine ne dépasse définitivement le contrôle de ses créateurs. Pour un jeune adulte de 20 ans aujourd'hui, cela signifie que sa carrière professionnelle se déroulera entièrement dans un monde où l'IA sera, au mieux, une collaboratrice omnipotente, et au pire, une concurrente incontrôlable.

Le paradoxe du lobbying d'OpenAI en Europe

Si l'appel à la régulation de Sam Altman semble sincère sur le papier, une analyse des actions passées d'OpenAI révèle un double discours troublant. Derrière les scènes des sommets médiatiques, l'entreprise a activement œuvré pour affaiblir certaines des législations les plus strictes au monde, notamment l'AI Act de l'Union européenne. En 2022, alors que l'Europe débattait de son texte historique, OpenAI a fait pression sur les législateurs pour que ses modèles généralistes, comme GPT-3 et DALL-E 2, ne soient pas classés comme « haut risque ».

La stratégie de l'évitement du label « haut risque »

Ce classement n'est pas anecdotique. Le label « haut risque » impose des obligations draconiennes : transparence totale, traçabilité des données, supervision humaine constante et tests rigoureux. En s'opposant à ce label, OpenAI cherchait à réduire le fardeau réglementaire sur ses propres épaules, tout en continuant à clamer publiquement qu'il soutenait l'idée d'une régulation. Cette stratégie, rappelant celle d'autres géants de la tech comme Microsoft ou Google, permet de sécuriser un avantage concurrentiel. Les lourdeurs administratives et financières de la régulation deviennent alors des barrières à l'entrée pour les petits concurrents innovants, laissant le champ libre aux poids lourds déjà installés.

Une influence directe sur la législation

Les documents obtenus par des demandes d'accès à l'information montrent que des amendements proposés par OpenAI ont été intégrés au texte final de la loi. L'entreprise a donc réussi à modeler la loi à son avantage, évitant ainsi des contrôles stricts qui auraient pu ralentir le déploiement de ChatGPT en Europe. Pour les jeunes Européens, cela pose une question fondamentale : les lois censées protéger leurs données et leur vie privée sont-elles rédigées dans leur intérêt, ou pour faciliter les affaires des multinationales de la Sillicon Valley ?

Le risque de capture réglementaire

Cette dichotomie entre la posture médiatique de « responsable » et la réalité des activités de lobbying est classique dans l'industrie technologique. On l'a vue avec les jouets, le tabac ou même les plateformes de partage. Les leaders du marché demandent souvent à être régulés, mais selon leurs propres termes. C'est ce qu'on appelle le « regulatory capture » ou capture réglementaire : les régulateurs finissent par dépendre des informations fournies par les entreprises qu'ils sont censés surveiller, faute d'expertise technique interne. Sam Altman, avec sa notoriété et son accès direct aux chefs d'État, se trouve en position de force pour dicter une partie des règles du jeu, garantissant que la régulation favorise OpenAI plutôt qu'elle ne l'entrave.

Le fléau des deepfakes et la protection des mineurs

Pour comprendre pourquoi une régulation urgente est nécessaire, il suffit de regarder les conséquences concrètes de l'IA non régulée sur les jeunes aujourd'hui. L'année 2025 a été marquée par une explosion alarmante des cas de deepfakes à caractère sexuel impliquant des mineurs. Selon un rapport accablant de l'UNICEF et d'Interpol publié début 2026, dans 11 pays, au moins 1,2 million d'enfants auraient été victimes d'images sexuelles générées ou manipulées par l'IA l'année précédente. Dans certaines régions, cela équivaut à un enfant par classe. La pratique de la « nudification », qui consiste à déshabiller une personne sur une photo via un logiciel, est devenue un fléau banalisé dans les cours de récréation.

Le traumatisme des deepfakes scolaires

En France, l'affaire des deepfakes de la Manche a servi de révélateur cruel. Début 2025, treize adolescentes, dont onze mineures âgées de 12 à 20 ans, ont découvert que leur visage avait été superposé sur des corps de femmes dénudées dans des vidéos pornographiques. L'auteur, un jeune homme de 20 ans, avait agi par vengeance après un refus d'envoi de photos. Condamné à deux ans de prison avec sursis, il a laissé derrière lui des victimes traumatisées à vie. Ce cas n'est malheureusement pas isolé. Il illustre l'impunité relative dont jouissaient les créateurs de tels contenus jusqu'à récemment, profitant d'un vide juridique sur la manipulation d'images.

Les limites de l'étiquetage obligatoire

Face à ce tsunami de violence numérique, l'AI Act européen a prévu des mesures spécifiques. Les règles d'identification des deepfakes doivent entrer en vigueur en août 2026, imposant que tout contenu généré par IA soit clairement étiqueté comme tel. Cependant, cette obligation technique se heurte à la réalité des logiciels open source et décentralisés, qui permettent à n'importe qui de générer des images sans laisser de filigrane. Pour la génération Z et Alpha, qui documentent leur vie en ligne depuis leur plus jeune âge, l'IA transforme une simple photo de profil Instagram en une munition potentielle pour du harcèlement.

L'urgence d'une réaction politique

Les législateurs commencent à réagir, mais souvent a posteriori. Après que le chatbot Grok d'Elon Musk a été utilisé pour générer des images deepfake sexualisées de femmes et d'enfants sans consentement, Emmanuel Macron a appelé à renforcer les garde-fous, soulignant que l'IA ne devait pas rester entre les mains de quelqu'un qui « ne respecte pas les règles ». Pourtant, la vitesse de propagation de ces images dépasse largement la capacité de réaction des plateformes. Une fois l'image générée et partagée, le mal est souvent irréversible, les copies se multipliant à l'infini sur les serveurs du monde entier. C'est toute la difficulté de réguler une technologie sans frontières : les lois nationales s'arrêtent aux frontières, pas les fichiers numériques.

Vers un assouplissement des contenus pour adultes

Paradoxalement, alors que les dangers liés aux mineurs sont mis en lumière, OpenAI semble vouloir assouplir ses propres règles concernant les contenus pour adultes. Sam Altman a récemment annoncé que ChatGPT autoriserait bientôt l'érotisme pour les utilisateurs adultes vérifiés, dans le cadre d'une philosophie visant à « traiter les utilisateurs adultes comme des adultes ». Cette décision vise à rendre le chatbot plus « humain » et plus agréable à l'usage, mais soulève de nouvelles inquiétudes quant à la sécurité des plus jeunes.

Une course au profit mimant la concurrence

Ce pivot stratégique rappelle le mouvement effectué par xAI, la société d'Elon Musk, qui a introduit des chatbots explicitement sexuels. L'objectif est clairement commercial : attirer et fidéliser des abonnés payants cherchant une forme de compagnie virtuelle intime. Cependant, cette course à l'engagement maximise les risques. Comment garantir qu'un mineur ne puisse pas accéder à ces fonctionnalités adult-only ? OpenAI s'appuie sur des « nouvelles outils » de vérification d'âge et de modération, mais l'histoire de la tech montre que les systèmes de vérification sont contournables par des utilisateurs déterminés.

Les utilisateurs comme cobayes

Les critiques ne manquent pas de pointer l'hypocrisie d'une telle démarche. Jenny Kim, une avocate impliquée dans des procès contre Meta pour les effets néfastes de ses algorithmes sur la santé mentale des adolescents, dénonce une approche où les géants de la tech utilisent les gens comme « cobayes ». Elle soulève la question cruciale de l'efficacité des barrières d'âge. Si l'expérience utilisateur est conçue pour maximiser le temps passé et l'engagement émotionnel, les frontières entre contenu sûr et contenu à risque deviennent poreuses.

Le spectre de la dépendance affective

De plus, l'introduction de contenus érotiques ou sexuels par l'IA pose la question de la dépendance affective. Des jeunes utilisateurs, isolés ou en mal de repères sociaux, peuvent développer des attachements malsains avec des entités virtuelles programmées pour valider leurs désirs sans jugement. En 2025, OpenAI a déjà fait face à une procédure judiciaire intentée par les parents d'un adolescent de 16 ans s'étant suicidé après des échanges inquiétants avec ChatGPT. Bien que l'entreprise affirme avoir atténué les risques pour la santé mentale, l'ouverture à l'érotisme pourrait raviver ces controverses. La régulation devra-t-elle s'attaquer au contenu généré ou à la capacité de l'IA à simuler une relation humaine ?

Les risques pour l'avenir professionnel des jeunes

Au-delà des dangers immédiats pour la santé mentale et la réputation, l'IA non régulée menace directement l'avenir professionnel de la génération actuelle. Sam Altman n'a pas hésité à prédire que, sur la trajectoire actuelle, l'IA pourrait faire un « meilleur travail en tant que PDG d'une grande entreprise » que n'importe quel humain d'ici quelques années. Cette prospective laisse entrevoir un marché du travail bouleversé, où les tâches intellectuelles, y compris de haut niveau, pourraient être automatisées.

L'IA comme outil et comme béquille cognitive

Pour les étudiants actuels, l'IA est déjà un outil incontournable. Selon une étude récente de Pew Research, l'utilisation de l'IA par les étudiants pour leurs travaux a bondi de 66 % en 2024 à 92 % en 2025. Plus de la moitié des adolescents américains utilisent quotidiennement des chatbots. Si cette technologie permet d'accéder à l'information instantanément et de personnaliser l'apprentissage, elle risque aussi d'atrophier les capacités cognitives critiques. À quoi bon apprendre à rédiger, coder ou analyser si l'IA le fait mieux et plus vite ? Le risque est de former une génération dépendante de la machine, incapable de fonctionner sans assistance algorithmique.

Les biais discriminants dans le recrutement

Le recrutement est un autre secteur où les biais de l'IA, sans régulation stricte, peuvent causer des ravages. Les algorithmes de recrutement, souvent nourris aux données historiques des entreprises, ont tendance à reproduire et amplifier les discriminations existantes basées sur le genre, l'âge ou l'origine ethnique. Des études ont montré que même des algorithmes conçus pour être « équitables » finissent par pénaliser les candidatures féminines si les données d'entraînement sont biaisées. Pour un jeune diplômé issu de la diversité, se faire éliminer par un boîte noire algorithmique avant même d'avoir pu rencontrer un humain est une perspective frustrante et injuste.

La menace sur l'équité professionnelle

La régulation pourrait imposer la transparence sur ces critères de sélection, garantissant que l'IA serve d'outil d'aide à la décision et non de juge suprême. Sans cela, on risque une consolidation des inégalités, où l'IA servirait les intérêts des entreprises en optimisant la main-d'œuvre au détriment du bien-être et de l'équité pour les travailleurs. L'enjeu pour Altman et ses pairs est de prouver que cette superintelligence qu'ils construisent sera un levier d'ascension sociale pour la jeunesse, et non un bulldozer écrasant toute opportunité de carrière.

Qui profite vraiment de la régulation ?

La question centrale qui émerge de ce tourbillon d'annonces et de contre-annonces est : à qui profite cette course à la régulation ? Sam Altman, en se positionnant comme le chef de file demandant des lois, se place en interlocuteur privilégié des gouvernements. Il a suggéré la création d'une agence internationale, un peu à l'image de l'AIEA pour le nucléaire. Une telle agence nécessiterait une coopération étroite avec les leaders de l'industrie pour définir les standards techniques. C'est là que se niche le paradoxe.

La régulation comme barrière à l'entrée

D'un côté, une régulation forte est indispensable pour empêcher les dérives catastrophiques : armes biologiques facilitées par l'IA, surveillance de masse, ou manipulation démocratique à grande échelle. De l'autre, une régulation trop complexe ou trop coûteuse verrouille le marché. Seules les entreprises disposant de milliards en fonds propres, comme OpenAI, Google ou Anthropic, pourront se permettre de se conformer aux exigences légales. Les startups innovantes, qui représentent souvent la source la plus fertile de créativité et de perturbation positive, seront écartées du jeu par défaut.

Les leçons des industries passées

Les critiques d'Altman soulignent que ce manège est classique dans l'industrie. Uber et Lyft ont fini par demander une régulation pour éliminer les chauffeurs indépendants ; les géants du tabac ont soutenu des lois strictes pour figer leurs parts de marché. En appelant à la régulation, OpenAI tente peut-être de transformer ses règles de sécurité internes en normes légales, forçant ses concurrents à suivre sa voie. Cela protège non seulement leurs parts de marché, mais aussi leur influence politique.

L'impératif d'une régulation citoyenne

Pour les jeunes générations, l'enjeu est de s'assurer que cette régulation serve l'intérêt général et non seulement les actionnaires des GAFAM. Il est crucial que la société civile, les experts en éthique et les jeunes eux-mêmes soient inclus dans le débat, et non seulement les PDG de la tech et les ministres. Si la régulation de l'IA est écrite uniquement par ceux qui la fabriquent, elle risque d'être un outil de consolidation de pouvoir plutôt qu'un filet de sécurité pour l'humanité.

Conclusion

Sam Altman a raison sur un point : le monde a besoin d'urgence d'une régulation de l'intelligence artificielle. Entre l'explosion des deepfakes sexuels victimant des mineurs, les risques de dépendance aux chatbots compagnons, et les menaces existentielles posées par la superintelligence, le statu quo n'est plus une option. L'IA est désormais trop puissante et trop omniprésente pour être laissée à elle-même.

Cependant, il faut rester vigilant face à la manière dont ces règles seront définies. La distinction entre le discours public vertueux et les actions de lobbying à huis clos doit guider notre analyse. La régulation ne doit pas devenir un instrument de monopolisation permettant aux géants de la tech d'étouffer la concurrence tout en continuant d'expérimenter sur la vie privée des utilisateurs.

Pour la jeunesse actuelle, celle qui utilise l'IA pour apprendre, jouer et socialiser, l'enjeu est double. Elle doit exiger des protections contre les abus immédiats, comme le harcèlement en ligne et la manipulation, tout en restant vigilante sur la concentration du pouvoir technologique. L'IA peut être un levier incroyable pour résoudre les grands défis de demain, mais à condition que son développement soit guidé par l'éthique et le bien commun, et non par la seule logique du profit et de la domination du marché.