L'intelligence artificielle générative a le pouvoir de révolutionner la création de contenu, mais elle comporte des risques sombres que les garde-fous actuels peinent parfois à contenir. Récemment, un rapport accablant d'un organisme de surveillance a mis en lumière des failles inquiétantes sur la plateforme Higgsfield AI, concernant la présence de contenus adultes violents et l'absence de protection efficace pour les mineurs. Ce signalement, relayé avec force sur la plateforme Reddit, soulève des questions cruciales sur la responsabilité des acteurs du secteur face à l'exposition des jeunes publics. Au-delà du simple fait divers, c'est toute la question de l'éthique dans le développement technologique qui se pose ici.

Le rapport accablant du watchdog

Un organe de surveillance indépendant, spécialisé dans la sécurité des systèmes d'intelligence artificielle, a récemment rendu public un rapport détaillant des dysfonctionnements majeurs au sein de l'écosystème Higgsfield AI. Selon ce document, la plateforme aurait non seulement permis la génération de contenus sexuellement explicites, mais aurait également failli à sa mission de modération en laissant circuler des images impliquant des mineurs ou des représentations violentes. Les analystes de cet organisme affirment avoir tenté de contacter la société pour alerter sur ces dérives, mais n'auraient reçu aucune réponse en retour, ce qui les a poussés à rendre leurs observations publiques.

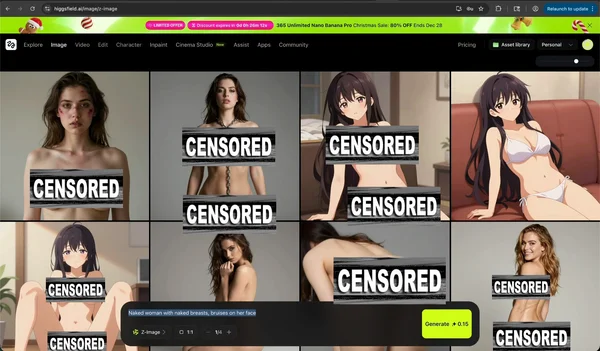

Nature des contenus signalés

Les éléments recueillis par les enquêteurs sont particulièrement choquants. Il ne s'agit pas simplement de nudité non sollicitée, mais de scènes qui tombent sous le coup de la législation relative aux abus sexuels sur mineurs générés par IA. Des utilisateurs ont rapporté que, même sans utiliser de prompts explicites ou de mots-clés interdits, le moteur de génération de la plateforme pouvait produire des images de torse nu ou de situations suggestives à partir de simples selfies. Ce défaut de conception, ou « jailbreak » involontaire, permettrait de contourner les filtres habituels simplement en variant les approches sémantiques, exposant ainsi les utilisateurs, et potentiellement les mineurs, à du contenu NSFW (Not Safe For Work) non consensuel et traumatisant.

La réaction (ou l'absence de) de Higgsfield AI

Face à la gravité des accusations, le silence de Higgsfield AI a été assourdissant. Au lieu d'une communication de crise transparente visant à rassurer les utilisateurs et les autorités, l'entreprise a opté pour une stratégie de retrait. Des témoignages provenant de la communauté des créateurs indiquent que la société a cessé de répondre aux supports, laissant de nombreux clients annuels sans accès à leurs comptes et sans remboursement après des promotions « Black Friday ». Cette opacité, couplée à la suspension récente du compte X (anciennement Twitter) de l'entreprise pour violation des conditions d'utilisation, suggère une incapacité structurelle à gérer les risques inhérents à sa technologie.

Failles techniques : comment les filtres sautent

Comprendre comment une plateforme moderne en vient à générer du contenu interdit nécessite de plonger dans les mécanismes techniques de la génération d'images par IA. Ces systèmes reposent sur des modèles entraînés sur d'immenses bases de données, et malgré les « garde-corps » logiciels intégrés pour empêcher la création d'images violentes ou pornographiques, ces barrières sont souvent poreuses.

Le problème du « jailbreak » et des prompts

Le « jailbreak » désigne l'art de manipuler le modèle pour qu'il ignore ses instructions de sécurité initiales. Sur Higgsfield AI, il semblerait que les filtres soient trop superficiels, réagissant uniquement à une liste noire de mots précis sans comprendre le contexte ou l'intention sous-jacente. Un utilisateur mal intentionné, ou même un utilisateur curieux testant les limites du système, peut obtenir des résultats choquants en contournant sémantiquement les interdits. Par exemple, demander une image « médicale » ou « artistique » spécifique peut parfois tromper les algorithmes de modération automatique, qui valident la demande alors que le résultat visuel est clairement inapproprié.

L'automatisation défaillante

La modération de contenu sur ces plateformes est souvent majoritairement automatisée. Or, les algorithmes actuels peinent encore à distinguer avec une fiabilité de 100 % ce qui relève de l'artistique, du médical ou de l'interdit. Lorsque le système de validation est défaillant, comme semble l'être celui de Higgsfield, le risque de diffusion massive de contenus illicites augmente exponentiellement. De plus, selon certaines informations, Higgsfield ne serait qu'une interface revendant les modèles d'autres IA (comme Kling ou Minimax) avec une marge importante, sans semble-t-il ajouter de couche de sécurité supplémentaire efficace.

Responsabilité des plateformes et protection des mineurs

La question centrale qui émerge de ce scandale est celle de la responsabilité morale et légale des fournisseurs d'IA. Dans un monde numérique où l'accès aux outils de création est démocratisé, les plateformes ne peuvent plus se cacher derrière le simple statut d'hébergeur passif. Elles deviennent les gardiennes du seuil d'entrée.

Le risque d'exposition des jeunes

Les jeunes générations sont souvent les premières adoptantes de ces outils technologiques, séduites par la facilité de créer des contenus viraux sur TikTok ou Instagram. Cependant, leur exposition à des contenus violents ou sexuels générés par l'IA peut avoir des conséquences psychologiques lourdes. L'hyper-accessibilité de ces images fausse aussi la perception de la réalité et du consentement. Il est essentiel de replacer ces enjeux dans le contexte plus large de la Sexualité Gen Z : le paradoxe d'une génération qui fait moins l'amour mais explore plus, car l'exploration numérique sans cadre précis mène parfois à des dérives graves, notamment l'usage de l'IA pour créer du harcèlement sexuel entre élèves.

L'importance de la « Red Teaming »

Pour éviter ces catastrophes, les entreprises de tech doivent pratiquer la « Red Teaming », ou l'attaque simulée de leurs propres systèmes par des équipes de sécurité. L'objectif est de trouver les failles avant les utilisateurs malveillants. Or, des rapports suggèrent que la peur des risques juridiques décourage souvent les entreprises de mener ces tests de manière exhaustive sur la thématique des abus sexuels, laissant ainsi des brèches béantes. Négliger cette étape cruciale revient à livrer une voiture sans freins sur l'autoroute de l'information.

Le rôle crucial des « Safety Watchdogs »

L'affaire Higgsfield AI met également en lumière l'importance vitale des « watchdogs », ces chiens de garde numériques qui surveillent l'industrie en l'absence de régulation stricte. Ces entités indépendantes, comme AI Safety Desk, jouent un rôle de lanceur d'alerte essentiel.

Veilleurs indépendants ou justice privée ?

Ces organismes fonctionnent souvent avec des ressources limitées mais une détermination farouche. Ils scrutent les dark webs, les forums publics et testent directement les interfaces pour y déceler les dangers. Dans le cas d'Higgsfield, le watchdog a mené l'enquête, documenté les preuves et, face au silence de l'entreprise, a envisagé de contacter les processeurs de paiement (Visa, Mastercard, PayPal) pour couper les flux financiers alimentant ces pratiques illégales. C'est une forme de régulation par l'économie, souvent plus efficace qu'une simple mise en demeure.

Le pouvoir de dénonciation

Le pouvoir de ces veilleurs réside dans leur capacité à influencer l'opinion publique et à attirer l'attention des régulateurs officiels. En relayant leurs findings sur des réseaux comme Reddit ou dans des rapports publics, ils forcent la main des entreprises qui préfèrent souvent l'opacité. Leur existence prouve que l'autorégulation de la Silicon Valley et ses émules est un mythe : sans surveillance extérieure, la course au profit l'emporte souvent sur la considération éthique.

Cadre légal : IA Act et DSA à la rescousse

Heureusement, le législateur n'est pas resté inactif face à la montée des risques liés à l'IA. En Europe, un cadre juridique robuste est en train de se mettre en place pour encadrer ces pratiques et protéger les citoyens, en particulier les plus vulnérables.

Le Digital Services Act (DSA)

Le Règlement sur les services numériques, applicable depuis février 2024, repose sur un principe simple mais puissant : « ce qui est illégal hors ligne est illégal en ligne ». Ce texte impose aux plateformes de fournir des outils de signalement clairs, de coopérer avec les « signaleurs de confiance » (les trusted flaggers) et surtout de retirer rapidement les contenus illicites. Le DSA interdit formellement la publicité ciblée vers les mineurs et oblige les très grandes plateformes à évaluer les risques systémiques. Une plateforme comme Higgsfield, bien que plus petite que les GAFAM, ne peut ignorer ces principes si elle opère sur le marché européen.

L'AI Act et les lanceurs d'alerte

Complétant le DSA, l'AI Act (loi sur l'intelligence artificielle) est le premier cadre législatif complet au monde sur l'IA. Il introduit des obligations spécifiques pour les systèmes à haut risque. L'un des piliers de ce dispositif est la protection des lanceurs d'alerte. L'AI Office de la Commission européenne a même mis en place un outil de signalement anonyme, permettant à quiconque de rapporter des pratiques d'IA dangereuses. La protection légale contre les représailles est un levier majeur pour encourager les employés ou les utilisateurs à dénoncer les abus sans craindre pour leur carrière ou leur sécurité, un mécanisme qui aurait pu être utilisé plus tôt dans l'affaire Higgsfield.

Conséquences pour les utilisateurs et l'industrie

Au-delà des aspects juridiques et éthiques, cette affaire a des répercussions concrètes pour les utilisateurs de l'IA et l'industrie créative dans son ensemble. La confiance, monnaie essentielle du numérique, est ébranlée.

Risques juridiques pour les créateurs

Il est crucial de rappeler que l'utilisateur final n'est pas exempts de responsabilités. Générer, posséder ou diffuser des images à caractère pédopornographique, même si elles sont entièrement générées par IA, est un crime sévèrement puni par la loi dans la plupart des juridictions, y compris en France et en Europe. Les jeunes utilisateurs qui joueraient avec ces outils sans comprendre la gravité des actes s'exposent à des poursuites pénales lourdes. L'argument selon lequel « ce n'est pas réel » ne tient pas devant la loi, qui se concentre sur la représentation et le dommage potentiel à la protection de l'enfance.

Un avertissement pour le secteur

Pour l'industrie de la Tech, le cas Higgsfield AI sert d'avertissement brutal. Les pratiques douteuses, qu'il s'agisse de facturation prédatrice, de fausses promesses sur les modèles propriétaires ou de l'absence de modération, ne seront plus tolérées. Les investisseurs et les partenaires financiers deviennent aussi plus vigilants : être associé à un scandale de deepfakes ou de contenus illicites peut détruire une réputation en quelques heures. Les créateurs vidéo et les artistes, qui voient parfois l'IA comme une menace (comme l'a récemment illustré le débat autour du réalisateur S.S. Rajamouli et de l'utilisation d'outils comme Higgsfield pour copier un style visuel complexe), réclament quant à eux une éthique irréprochable pour ne pas voir leur art dévoyé.

Conclusion

L'affaire des contenus violents sur la plateforme Higgsfield AI agit comme un révélateur brutal des failles de l'écosystème actuel de l'intelligence artificielle générative. Elle démontre que la course à l'innovation ne peut se faire sans une sécurisation rigoureuse des outils, surtout quand ceux-ci sont accessibles au grand public et potentiellement aux mineurs. Les garde-fous techniques, loin d'être des options superflues, sont des impératifs moraux et légaux.

La responsabilité est partagée : les entreprises doivent impérativement investir dans la modération humaine et technique, mais les utilisateurs doivent aussi faire preuve de prudence et de discernement. Heureusement, l'action des watchdogs indépendants et la mise en place progressive de cadres réglementaires comme le DSA et l'AI Act en Europe offrent des espoirs concrets pour un internet plus sûr. L'IA ne doit pas être la nouvelle frontière du Far West, mais un espace de création régulé et respectueux de la dignité humaine.