À peine trois mois après la sortie de son prédécesseur, Google frappe un grand coup avec Gemini 3.1 Pro, un modèle d'intelligence artificielle qui redéfinit les standards du raisonnement machine. En passant de moins de 40 % à 77,1 % sur le redouté benchmark ARC-AGI-2, l'entreprise de Mountain View prouve que l'amélioration continue des grands modèles de langage n'est pas un mythe, mais une réalité industrielle fulgurante. Cette avancée ne se limite pas à des statistiques de laboratoire ; elle se traduit par une capacité inédite à résoudre des problèmes complexes, coder et synthétiser des informations volumineuses, tout en restant accessible financièrement. Plongeons dans les détails de cette mise à jour qui pourrait bien faire basculer la donne dans la guerre de l'IA face à des concurrents comme ChatGPT : le guide complet de l'IA générative.

De 40% à 77% sur ARC-AGI-2 : le bond statistique qui change tout

L'annonce principale qui agite le secteur technologique en ce mois de février 2026 concerne une amélioration vertigineuse des capacités cognitives de l'IA. En trois mois seulement, Google a fait passer Gemini 3 Pro d'un score inférieur à 40 % sur le benchmark de raisonnement abstrait ARC-AGI-2 à 77,1 % avec Gemini 3.1 Pro. Ce n'est pas une simple mise à jour de routine ; c'est un doublement de performance qui propulse le modèle californien au sommet des classements mondiaux en termes de rapport qualité-prix. Pour comprendre l'ampleur de cet exploit, il faut saisir ce que mesure réellement cet test spécifique. Contrairement aux évaluations classiques qui se contentent de vérifier la connaissance encyclopédique ou la capacité à prédire le mot suivant, ARC-AGI-2 teste la capacité de l'IA à généraliser à partir de très peu d'exemples, une compétence souvent considérée comme le saint graal de l'intelligence artificielle.

Cette progression fulgurante positionne Gemini 3.1 Pro bien au-delà des attentes habituelles du secteur. D'ordinaire, les gains de performance entre deux versions successives d'un modèle se mesurent en pourcents à un chiffre. Ici, nous parlons d'un bond de près de 40 points de pourcentage. Google qualifie lui-même cette avancée de « step forward in core reasoning », signalant que l'on a affaire à une amélioration fondamentale de la manière dont la machine « pensait » auparavant. C'est un tournant majeur pour les développeurs et les entreprises qui cherchent des outils capables de comprendre des nuances logiques plutôt que de simplement réciter des manuels scolaires. Ce score de 77,1% est d'autant plus spectaculaire qu'il place le modèle de Google en tête des modèles généralistes, devançant largement des concurrents qui faisaient la loi jusqu'alors sur les tâches d'analyse complexe.

Pourquoi ARC-AGI-2 terrifie encore les modèles d'IA

Le benchmark ARC-AGI (Abstraction and Reasoning Corpus) est considéré par beaucoup de chercheurs comme l'un des tests les plus difficiles à passer pour une intelligence artificielle. Contrairement au MMLU ou au HumanEval, qui peuvent souvent être réussis par simple mémorisation de patterns vus lors de l'entraînement, ARC-AGI-2 mesure la capacité à résoudre des grilles logiques basées sur des concepts jamais vus auparavant. Il ne s'agit pas de réciter une connaissance stockée dans une base de données, mais de véritablement « raisonner » pour déduire une règle de transformation abstraite. C'est la raison pour laquelle ce benchmark est devenu la référence absolue pour évaluer le « vrai raisonnement » et la capacité de généralisation des systèmes actuels.

Le fait que Gemini 3.1 Pro atteigne désormais 77,1 % sur cette épreuve signifie que les ingénieurs de DeepMind ont réussi à réduire considérablement l'écart entre l'analyse statistique et le raisonnement conceptuel. C'est une percée significative car ce benchmark résistait obstinément aux modèles précédents, qui plafonnaient souvent autour de 40-50 %. Atteindre un tel niveau indique que le modèle ne se contente plus de deviner la réponse en se basant sur des similarités superficielles avec ses données d'entraînement, mais qu'il parvient à construire une représentation interne du problème posé. Pour les utilisateurs, cela se traduit par une IA beaucoup plus fiable lorsqu'elle est confrontée à des situations inédites, des défis logiques ou des problèmes nécessitant une véritable compréhension des causes et des effets.

La timeline fulgurante : 18 novembre 2025 au 19 février 2026

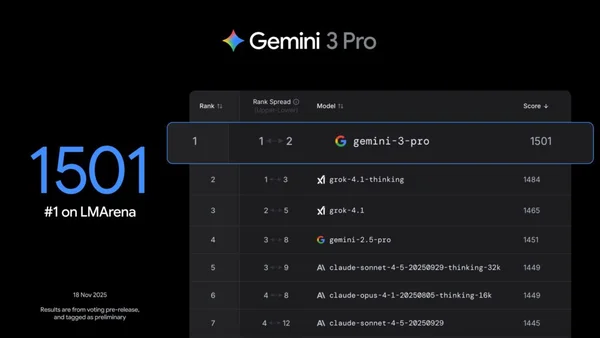

L'histoire de cette amélioration est presque aussi fascinante que le résultat lui-même. Il faut se rappeler que la version précédente, Gemini 3 Pro, a été lancée seulement le 18 novembre 2025. Moins de quatre-vingt-douze jours plus tard, le 19 février 2026, Google dévoilait Gemini 3.1 Pro avec des capacités de raisonnement doublées. Dans le monde du développement de l'intelligence artificielle, une telle itération est extrêmement rapide, voire inédite pour un modèle de cette envergure. D'habitude, les cycles de développement pour des LLM (Large Language Models) de pointe s'étalent sur six mois à un an. Ici, les équipes de Google ont réussi à identifier les failles de raisonnement de la version 3, à les corriger et à déployer une version améliorée en à peine trois mois.

Cette rapidité soulève des questions passionnantes sur les méthodes utilisées par Google. A-t-on affaire à une simple optimisation des paramètres existants, ou à une nouvelle méthode d'entraînement ? Certains experts suggèrent que Google pourrait désormais utiliser ses propres modèles pour aider à en entraîner d'autres, créant une boucle de rétroaction positive qui accélère le progrès. Quoi qu'il en soit, ce rythme d'itération effréné met une pression énorme sur la concurrence. Si Google est capable de doubler les performances de son modèle fleuve en un trimestre, le paysage de l'IA risque de changer encore radicalement d'ici l'été 2026. C'est une course contre la montre où les trois derniers mois viennent de redéfinir les règles du jeu.

Ce qui a changé sous le capot : thinking_level et architecture multimodale

Après avoir établi l'ampleur du progrès, il est essentiel de comprendre les innovations techniques qui ont rendu ce saut qualitatif possible. Gemini 3.1 Pro n'est pas simplement une version « plus grosse » de son prédécesseur ; elle intègre des changements structurels majeurs dans la manière dont l'utilisateur interagit avec le modèle et dont celui-ci traite l'information. L'une des modifications les plus notables concerne le remplacement de l'ancien paramètre « thinking_budget » par un nouveau paramètre « thinking_level ». Cette évolution sémantique cache une réalité technique profonde : au lieu de simplement allouer une quantité brute de ressources au calcul, le système peut désormais doser la profondeur de réflexion de manière plus fine et adaptative. C'est une évolution ergonomique majeure pour les développeurs, offrant un contrôle sans précédent sur le compromis entre vitesse de réponse et profondeur d'analyse.

Parallèlement à cela, l'architecture nativement multimodale a été renforcée pour exploiter pleinement une fenêtre de contexte élargie à 1 million de tokens. Ce n'est pas un gadget marketing : cela signifie concrètement que l'on peut injecter des volumes de données auparavant impossibles à traiter en une seule session de travail. Que ce soit des centaines de pages de documentation technique, des bases de code entières, ou des heures d'audio transcrit, Gemini 3.1 Pro peut désormais « lire » et synthétiser des masses d'informations hétérogènes sans perdre le fil. Ces changements ne sont pas cosmétiques ; ils constituent le fondement même des performances observées sur ARC-AGI-2. En permettant au modèle de « voir » plus de contexte et de réfléchir plus profondément sur commande, Google a armé son IA pour affronter les problèmes complexes avec une efficacité nouvelle.

Le paramètre thinking_level : doser la profondeur de réflexion à la demande

Le passage de « thinking_budget » à « thinking_level » représente une maturation significative de l'approche de Google concernant le raisonnement des LLM. Avec l'ancien système, les développeurs devaient estimer combien de « budget » de calcul allouer à une tâche, une approche souvent imprécise qui gaspillait parfois des ressources ou au contraire limitait la réflexion de l'IA. Avec « thinking_level », l'utilisateur peut désormais indiquer le niveau de profondeur souhaité (par exemple sur une échelle de 1 à 5 ou qualitative), laissant le modèle optimiser lui-même ses processus internes de réflexion. C'est un peu comme passer d'une pédale d'accélérateur rudimentaire à un régulateur de vitesse intelligent sur une voiture moderne.

Prenons un exemple concret : pour un résumé simple d'un article de presse, un niveau bas suffira et la réponse sera instantanée. En revanche, pour analyser la cohérence d'un système juridique complexe ou résoudre un bug subtil dans un code de 50 000 lignes, le développeur pourra augmenter le « thinking_level ». Le modèle prendra alors le temps de générer des étapes intermédiaires de raisonnement, d'explorer différentes hypothèses et de vérifier ses propres conclusions avant de fournir une réponse. Cette flexibilité est cruciale pour optimiser le rapport coût/performance selon le type de requête, permettant aux entreprises de maîtriser leur facture tout en disposant d'une puissance de feu débloquée quand la situation l'exige. C'est un outil formidable pour les ingénieurs qui cherchent à intégrer l'IA dans des flux de travail critiques.

1 million de tokens : traiter des datasets entiers en une seule requête

La fenêtre de contexte d'1 million de tokens est sans doute l'une des fonctionnalités les plus sous-estimées par le grand public, mais qui excitent le plus les chercheurs et les développeurs. Pour mettre les choses en perspective, un token correspond approximativement à quatre caractères en anglais, ou à trois-quatre mots en français selon la complexité. Un million de tokens, c'est l'équivalent d'environ 700 000 mots, soit plus de mille pages de texte dense. C'est suffisant pour ingérer la documentation complète d'un langage de programmation, les archives d'une correspondance judiciaire sur plusieurs années, ou même plusieurs romans à la fois pour en extraire des thèmes transversaux.

Cette capacité change radicalement la donne pour les cas d'usage entreprise. Auparavant, pour analyser un grand dataset, il fallait le découper en petits morceaux (chunks), traiter chaque morceau séparément, puis tenter de recoller les morceaux, ce qui générait souvent des pertes d'information contextuelles. Avec Gemini 3.1 Pro, on peut alimenter le modèle avec l'intégralité des données pertinentes en une seule passe. L'IA peut alors croiser les informations situées au début et à la fin du document, repérer des contradictions à long terme et synthétiser une vision globale. Pour un consultant analysant des rapports financiers annuels ou un développeur cherchant à comprendre l'architecture d'un logiciel hérité, c'est la promesse de gagner des heures, voire des jours de travail. C'est cette capacité à ingérer et à faire sens de vastes océans de données qui sous-tend la capacité de l'IA à résoudre les problèmes complexes d'aujourd'hui.

Les démonstrations qui font mal : SVG animés, dashboards aérospatiaux et simulations 3D

La théorie, c'est bien, mais la pratique, c'est mieux. Google a accompagné l'annonce de Gemini 3.1 Pro d'une série de démonstrations qui laissent pantois. Loin des exemples académiques habituels, ces showcases illustrent une capacité de production technique directement exploitable dans le monde réel. Trois capacités spectaculaires ont été mises en avant : la génération d'animations SVG sophistiquées depuis un simple prompt texte, la synthèse d'un système complexe comme un dashboard aérospatial alimenté par de la télémétrie en temps réel, et le design interactif avec une simulation 3D de vol d'étourneaux réagissant à la gestuelle de l'utilisateur. Ces exemples ne servent pas juste à épater la galerie ; ils prouvent que Gemini 3.1 Pro ne se contente pas de « mieux répondre » aux questions triviales, mais qu'il agit comme un véritable copilote technique capable de générer du code fonctionnel et complexe.

Ce qui marque dans ces démos, c'est la précision technique. L'IA ne se trompe pas dans la syntaxe du code SVG, elle comprend les concepts de physique nécessaires pour simuler le vol des oiseaux, et elle sait structurer une interface utilisateur pour afficher des données de vol spatial. C'est le passage du « parlons de code » au « écrivons du code ». Pour les professionnels du développement web, de la data science ou de l'ingénierie, ces démos envoient un message clair : l'outil est prêt à sortir du laboratoire pour entrer dans les chaînes de production. Ce saut qualitatif dans la génération de contenu technique actif et interactif est sans doute l'un des aspects les plus prometteurs de cette nouvelle version.

Des animations SVG en code pur : la fin des images lourdes ?

La capacité à générer des SVG (Scalable Vector Graphics) animés depuis un prompt texte est une révolution pour les développeurs front-end et les designers techniques. Contrairement aux formats traditionnels comme le JPEG ou le PNG qui sont des images raster composées de pixels fixes, le SVG est un code XML qui décrit des vecteurs. L'avantage est immense : le fichier est extrêmement léger, on peut modifier chaque couleur ou forme par une simple ligne de code, et l'image reste parfaitement nette à n'importe quelle échelle de zoom. Avec Gemini 3.1 Pro, demander « Crée une icône de serveur animé avec un signal de chargement pulsant » ne génère pas une image pixelisée, mais du code source propre et optimisé que l'on peut copier-coller directement dans un site web.

Cela ouvre des perspectives considérables pour les interfaces web et les visualisations de données. Fini les lourdes bibliothèques d'images pour changer une couleur de bouton ; l'IA peut désormais générer sur mesure des illustrations dynamiques qui s'intègrent parfaitement au design system d'une application. Pour un prototype interactif, c'est un gain de temps massif. On peut imaginer des scénarios où un designer décrit une interaction complexe à l'IA, et celle-ci produit l'animation SVG correspondante en quelques secondes, prête à être testée par les développeurs. C'est la promesse d'une fusion plus étroite entre le design créatif et l'ingénierie logicielle, facilitée par une IA qui comprend les deux langages.

Dashboard ISS et vol d'étourneaux : quand l'IA comprend les systèmes complexes

Deux démonstrations spécifiques ont particulièrement retenu l'attention des observateurs. La première concerne la création d'un dashboard aérospatial affichant la télémétrie de la Station Spatiale Internationale (ISS) en temps réel. Ce n'est pas seulement un joli tableau ; l'IA a dû comprendre comment structurer les données de télémétrie hétérogènes (vitesse, altitude, température, niveau d'oxygène) et les présenter de manière lisible et cohérente pour un astronaute ou un ingénieur au sol. Cela prouve que Gemini 3.1 Pro possède une aptitude à synthétiser des flux de données complexes et à construire des interfaces utilisateurs professionnelles.

La deuxième démo, peut-être plus poétique mais techniquement tout aussi impressionnante, est la simulation 3D d'un vol d'étourneaux (murmuration) pilotée par le suivi des mouvements de la main (hand-tracking). L'IA a généré le code physique pour simuler le comportement collectif des oiseaux (le fameux « boids algorithm ») et l'a lié aux capteurs de la caméra pour que l'utilisateur puisse « interagir » avec l'essaim en temps réel. Ces deux exemples montrent que Gemini 3.1 Pro peut servir de « cerveau » à des systèmes complexes, intégrant des entrées sensorielles, des règles physiques et des interfaces de visualisation. Ce ne sont plus de simples chatbots textuels, mais les prémices d'agents autonomes capables de manipuler des environnements virtuels.

Gemini 3.1 Pro contre le reste du monde : Claude, GPT-5.2 et Grok passés au crible

Une fois la technique et les démos passées au crible, il est temps de regarder la carte du monde. Où se situe Gemini 3.1 Pro par rapport à ses rivaux ? Au 19 février 2026, les données du leaderboard ARC-AGI-2 sont sans appel : Gemini 3.1 Pro domine largement la catégorie des modèles généralistes avec un score de 77,1 %. Il devance nettement Claude Opus 4.6 (65 %) et Claude Sonnet 4.6 (59 %), les modèles phares d'Anthropic. Du côté d'OpenAI, le GPT-5.2 Refined atteint environ 70 %, mais à un coût bien plus élevé. Quant à Grok 4 Refined, le modèle de xAI, il affiche un score d'environ 28 %, le plaçant loin derrière les leaders actuels. Ce classement montre que Google a réussi à non seulement rattraper son retard, mais aussi à prendre une avance significative sur le raisonnement abstrait.

Cependant, le raisonnement n'est pas le seul terrain de bataille. Si l'on élargit l'analyse aux benchmarks de code et de connaissances, Gemini 3.1 Pro continue de briller. Sur LiveCodeBench Pro, il atteint 2887 Elo, contre 2439 pour son prédécesseur et 2393 pour GPT-5.2. C'est une progression notable qui indique une meilleure maîtrise des langages de programmation et de la logique algorithmique. De même, sur des tests de connaissances pointues comme MMLU (92,6 %) ou GPQA Diamond (94,3 %), le modèle de Google se classe en tête, prouvant que l'amélioration du raisonnement ne s'est pas faite au détriment de la culture générale. C'est un profil très complet qui en fait un candidat sérieux pour le titre de « meilleur modèle du monde » pour l'instant.

Le classement ARC-AGI-2 : Gemini 3.1 Pro en roi du rapport qualité-prix

L'analyse du tableau comparatif ARC-AGI-2 révèle une stratégie de prix très agressive de la part de Google. Gemini 3.1 Pro atteint ses 77,1 % pour un coût intermédiaire, ce qui en fait le choix le plus rationnel pour la grande majorité des cas d'usage. À titre de comparaison, GPT-5.2 Refined plafonne à environ 70 % pour un coût estimé entre 10 et 100 dollars par tâche complexe, ce qui peut devenir prohibitif pour un usage intensif. Seul le modèle « Deep Think » de Google, spécialisé dans la recherche avancée, fait mieux que 3.1 Pro avec un score avoisinant les 85 %, mais son temps de calcul et son coût le réservent à des applications ultra-spécifiques comme la recherche scientifique fondamentale.

Ce positionnement fait de Gemini 3.1 Pro le « sweet spot » du marché. Pour un développeur ou une entreprise, le calcul est simple : pourquoi payer beaucoup plus cher pour GPT-5.2 qui obtient un score inférieur sur le raisonnement ? Google attaque ici le marché sur son flanc le plus sensible, la rentabilité pour les entreprises. En proposant le meilleur score de raisonnement à un prix abordable, Google met la pression sur ses concurrents pour qu'ils baissent leurs tarifs ou qu'ils améliorent drastiquement leurs modèles. C'est une stratégie gagnant-gagnant pour l'utilisateur final, qui profite d'une puissance de calcul accrue sans voir sa facture exploser. C'est sans doute cette combinaison performance-prix qui expliquera l'adoption massive de ce modèle dans les mois à venir.

Code, connaissances, expertise : les autres victoires de Gemini 3.1 Pro

Si le raisonnement abstrait fait la une, il ne faut pas négliger les autres domaines où Gemini 3.1 Pro excelle. Le benchmark SWE-Bench Verified, qui teste la capacité d'une IA à résoudre des bugs réels issus de dépôts GitHub, est particulièrement éloquent. Avec un score de 80,6 %, Gemini 3.1 Pro est quasiment à égalité avec Claude Opus 4.6 (80,8 %), qui était jusqu'ici le roi incontesté du code. C'est une performance remarquable qui valide l'utilisation de ce modèle pour l'audit de code et la correction de bugs en production. Pour les équipes de développement, c'est la promesse d'un assistant technique capable de comprendre la structure d'un projet complexe et de proposer des corrections fonctionnelles sans intervention humaine excessive.

Sur les tests de connaissances académiques et d'expertise (MMLU, GPQA Diamond), les scores sont également au sommet des classements mondiaux. Cela signifie que le modèle ne sacrifie pas son encyclopédie interne pour mieux réfléchir. Il est capable d'utiliser sa vaste base de connaissances pour alimenter son raisonnement, créant une synergie entre mémoire et logique. Que ce soit pour rédiger un article médical, analyser une situation géopolitique ou concevoir une stratégie d'entreprise, Gemini 3.1 Pro dispose des briques élémentaires nécessaires et de la « colle » intellectuelle pour les assembler correctement. C'est cette polyvalence, couplée à une profondeur de raisonnement accrue, qui rend le modèle si dangereux pour la concurrence.

Ce qu'en disent ceux qui l'utilisent : les retours de JetBrains, Databricks et Cartwheel

Les benchmarks en laboratoire sont une chose, l'usage réel en est une autre. Heureusement, Google n'a pas attendu pour laisser des partenaires tester le modèle en conditions réelles. Plusieurs témoignages clients ont été partagés, et ils dressent un portrait très flatteur de Gemini 3.1 Pro. JetBrains, l'éditeur célèbre pour ses environnements de développement intégrés (IDE) comme IntelliJ ou PyCharm, rapporte une amélioration significative par rapport à la version précédente. Vladislav Tankov, un porte-parole de l'entreprise, a indiqué avoir observé « jusqu'à 15 % d'amélioration » par rapport à Gemini 3 Pro, décrivant le nouveau modèle comme « plus fort, plus rapide, plus efficace ».

Ces retours ne sont pas isolés. Databricks, la géante de la gestion de données et de l'IA, parle de « résultats impressionnants en raisonnement enterprise » et souligne que Gemini 3.1 Pro est « best-in-class » sur OfficeQA, un benchmark interne d'assessment que l'entreprise utilise pour juger la pertinence des IA dans un contexte bureautique professionnel. De son côté, Cartwheel, une entreprise spécialisée dans la visualisation de données, évoque une « compréhension substantielle » du code et des transformations de données. Ces éléments de feedback donnent de la chair à l'article et rassurent le lecteur sur l'utilité réelle du modèle au-delà des chiffres marketing. On est loin du jouet de recherche ; c'est un outil mûr pour les cas d'usage professionnels exigeants.

JetBrains : « 15% d'amélioration, plus fort, plus rapide, plus efficace »

Pour comprendre le poids de ce témoignage, il faut saisir qui est JetBrains. Cette entreprise fournit les outils utilisés quotidiennement par des millions de développeurs professionnels dans le monde entier. Si JetBrains intègre Gemini 3.1 Pro dans ses flux de travail et constate un gain de 15 %, cela se traduit par des millions d'heures de travail économisées à l'échelle planétaire. Le terme « plus rapide » est ici crucial : dans le monde du développement logiciel, le temps de réponse de l'IA impacte directement la fluidité de la programmation (le « flow »). Un modèle qui répond vite sans sacrifier la qualité permet de maintenir le développeur dans un état de concentration optimal.

L'aspect « plus efficace » suggère également que le modèle nécessite moins de corrections ou de « répétitions » de prompts de la part de l'utilisateur. Les ingénieurs de JetBrains utilisent ces modèles pour la complétion de code, l'analyse automatique de code et même la génération de tests unitaires. Une amélioration de 15 % sur ces tâches signifie des tests plus robustes, un code plus propre et moins de bugs en production. Pour une équipe de développement, c'est un avantage compétitif direct. C'est ce genre de retour concret, basé sur l'expérience terrain de grandes entreprises technologiques, qui valide véritablement les promesses de Google.

Databricks et Cartwheel : l'IA au service de l'entreprise

Les retours de Databricks et Cartwheel complètent le tableau en montrant que l'excellence de Gemini 3.1 Pro ne se limite pas au code pur. Databricks, qui traite des pétaoctets de données pour ses clients, insiste sur le « raisonnement enterprise ». Cela désigne la capacité de l'IA à naviguer dans des contextes d'affaires complexes, comprendre le jargon spécifique à une entreprise et gérer des données sensibles ou structurées de manière pertinente. Être « best-in-class sur OfficeQA » signifie que l'IA est meilleure que ses concurrents pour comprendre des documents Word, des feuilles Excel ou des présentations PowerPoint, le quotidien de tout employé de bureau.

Cartwheel, quant à elle, met l'accent sur la compréhension substantielle des transformations de données. Cela suggère que Gemini 3.1 Pro est capable de modifier, reformater ou analyser des jeux de données complexes sans les corrompre, une tâche souvent délicate pour les modèles de langage classiques qui tendent à « halluciner » des chiffres. Ensemble, ces témoignages positionnent Gemini 3.1 Pro comme un outil polyvalent, capable de passer du code source complexe aux tableurs Excel sans perte de pertinence. C'est cette versatilité qui en fait une solution attractive pour les grandes entreprises cherchant à standardiser leurs outils IA autour d'un modèle unique performant.

Deux dollars le million de tokens : l'arme fatale de Google

Au-delà de la performance brute, il est un facteur décisif dans l'adoption massive d'une technologie : le prix. Et c'est là que Google joue son atout maître avec une agressivité tarifaire qui pourrait bien faire hurler la concurrence. Gemini 3.1 Pro est facturé 2 dollars par million de tokens en entrée et 12 dollars par million de tokens en sortie pour des contextes standards (moins de 200k tokens). Pour les contextes longs, cette fameuse fenêtre de 200k à 1M tokens, les tarifs grimpent légèrement à 4 dollars en entrée et 18 dollars en sortie. Pour mémoire, ces tarifs sont identiques à ceux de la version précédente, ce qui signifie que Google offre une performance doublement meilleure sur le raisonnement pour le même prix.

C'est une stratégie en forme d'arme fatale. Dans un marché où le coût de calcul est un goulot d'étranglement majeur pour l'innovation, proposer un modèle de pointe à ce prix plancher brise les barrières à l'entrée. Pour une startup ou une PME, tester ou déployer l'IA devient une décision financière bien plus facile à prendre. Comparé aux estimations de coûts pour les modèles concurrents comme GPT-5.2, qui peuvent coûter entre 10 et 100 dollars pour certaines tâches complexes, le modèle de Google est imbattable sur le TCO (Total Cost of Ownership). C'est une approche classique de Google : conquérir le marché par la qualité et le prix, pour verrouiller ensuite les écosystèmes autour de ses solutions cloud et de ses outils de développement.

Le calcul rapide : combien coûte une vraie session de travail

Pour que cela soit concret, essayons de chiffrer une session de travail. Imaginez que vous utilisiez Gemini 3.1 Pro pour analyser la documentation complète d'une API et rédiger un module de code de 1000 lignes. Vous pourriez envoyer 500 000 tokens de documentation (environ 350 pages de texte) et recevoir 50 000 tokens de code en retour. Avec le tarif « contexte long » (4 $ / M tokens entrée, 18 $ / M tokens sortie), cette session coûterait environ 2 dollars en entrée (0,5 M * 4 $) et moins d'un dollar en sortie (0,05 M * 18 $). Soit un total d'environ 3 dollars pour une tâche qui prendrait plusieurs heures à un développeur senior facturé bien plus cher.

Même pour un usage intensif quotidien, la facture reste maîtrisée. Pour 10 dollars, vous pouvez traiter plusieurs millions de tokens, ce qui représente des volumes de travail colossaux. Cette accessibilité financière encourage l'expérimentation. Les développeurs n'hésiteront pas à demander à l'IA de réécrire du code, de proposer des optimisations ou de générer de la documentation, car le coût marginal de ces requêtes est infime. C'est cette dynamique qui permet l'innovation : quand l'intelligence de calcul devient aussi bon marché que l'électricité, de nouvelles applications émergent naturellement. Google l'a bien compris, et ce pricing est le levier principal pour accélérer l'adoption de Gemini 3.1 Pro face à ChatGPT : le guide complet de l'IA générative et autres solutions propriétaires.

Où et comment y accéder dès aujourd'hui

Tous ces discours sur les performances et les tarifs seraient vains si le modèle restait enfermé dans un laboratoire. Heureusement, Google a rendu Gemini 3.1 Pro largement accessible dès le jour de son annonce. Le modèle est disponible en preview via plusieurs canaux distincts, couvrant aussi bien le grand public que les développeurs avertis et les grandes entreprises. L'accès le plus direct passe par l'application Gemini mobile et web. Pour les utilisateurs standards, les limites d'utilisation ont été relevées, offrant une expérience plus fluide. Cependant, c'est avec les abonnements Google AI Pro et Ultra que l'on peut réellement tirer parti des capacités étendues du modèle, notamment cette fameuse fenêtre de contexte d'un million de tokens et le mode « Deep Think » pour les abonnés Ultra.

Pour les chercheurs et les analystes, NotebookLM est l'autre porte d'entrée majeure. Cet outil, qui permet de discuter avec ses documents, intègre désormais Gemini 3.1 Pro. Il faut noter toutefois que l'accès à NotebookLM avec ce nouveau modèle est réservé aux abonnements Pro et Ultra, positionnant clairement ces offres comme des solutions premium pour les travailleurs du savoir. Enfin, pour la communauté technique, l'accès se fait bien entendu via l'API, permettant l'intégration dans des applications tierces. C'est via ces multiples points d'entrée que Google espère inonder le marché et rendre son modèle incontournable.

Gemini App et NotebookLM : l'accès grand public et pro

L'application Gemini est le visage public de cette intelligence artificielle. Avec la mise à jour 3.1 Pro, les utilisateurs vont remarquer une nette amélioration de la qualité des réponses, surtout sur les questions complexes ou les demandes d'analyse approfondie. Pour un abonné « Google AI Pro », l'expérience est particulièrement enrichie car les limitations de nombre de requêtes sont repoussées, permettant d'utiliser l'IA comme un véritable assistant personnel pour le travail ou l'étude. L'interface reste la même, simple et intuitive, mais le « moteur » sous le capot est désormais beaucoup plus puissant, capable de suivre des chaînes de raisonnement plus longues sans se perdre.

NotebookLM, quant à lui, gagne en puissance avec cette intégration. Imaginez que vous êtes un étudiant ou un journaliste : vous pouvez charger des dizaines d'articles de recherche ou des transcriptions d'entretiens dans NotebookLM, et demander à Gemini 3.1 Pro d'en extraire les contradictions, de synthétiser les points clés ou de générer un plan détaillé. Grâce à la fenêtre de contexte étendue, l'IA peut se souvenir d'un détail mentionné dans le tout premier document tout en analysant le dernier, ce qui était souvent le point faible des anciens modèles. C'est un outil pédagogique et analytique redoutable, accessible sans coder une seule ligne, ce qui démocratise l'accès à une analyse de données de très haut niveau pour les non-techniciens.

API et Vertex AI : pour les développeurs et entreprises

Pour les développeurs, le véritable champ de bataille se joue sur l'infrastructure. Google propose l'accès à Gemini 3.1 Pro via AI Studio, l'environnement de prototypage rapide, et Vertex AI, la plateforme de production pour les entreprises. AI Studio permet de tester le modèle, de régler les paramètres comme « thinking_level » et de voir les coûts en temps réel. C'est l'endroit idéal pour expérimenter avant de déployer. Une fois le modèle calibré, Vertex AI offre la robustesse, la sécurité et la scalabilité nécessaires pour l'intégrer dans des applications client ou des flux de travail d'entreprise (SaaS, CRM interne, etc.).

De plus, Google a pensé aux outils spécifiques comme Android Studio pour le développement mobile, et même une interface en ligne de commande (Gemini CLI) pour les utilisateurs de terminal qui préfèrent la frappe au clic. Il existe également des plateformes partenaires comme Antigravity qui offrent des passerelles vers ces modèles. Cette ubiquité dans les outils de développement montre que Google ne se contente pas de vendre un modèle, mais construit tout un écosystème technique. Pour une entreprise CTO ou ingénieur, adopter Gemini 3.1 Pro est techniquement simple, car il s'intègre naturellement dans les chaînes d'outils Google Cloud déjà existantes. C'est un facteur clé de friction en moins face à des solutions qui nécessiteraient une refonte de l'infrastructure.

Deep Think, Flash et la famille Gemini : où se situe 3.1 Pro ?

Avec la multiplication des modèles, il est facile de s'y perdre. Où se place exactement Gemini 3.1 Pro dans la grande famille Google ? Pour faire simple, il est le modèle « Workhorse », le cheval de bataille robuste et intelligent. En dessous de lui, on trouve Gemini 3 Flash, le modèle par défaut de l'application, conçu pour la vitesse et les tâches quotidiennes. Au-dessus, on trouve le mode « Deep Think », réservé aux abonnés Ultra, pour les tâches de recherche ultime. Gemini 3.1 Pro se situe donc dans ce « Juste Milieu » : il est nettement plus intelligent que Flash, mais beaucoup plus rapide et économique que Deep Think. C'est le modèle recommandé pour les tâches professionnelles exigeantes qui ne nécessitent pas les cycles de raisonnement itératifs extrêmes de la recherche scientifique.

Comprendre cette hiérarchie est crucial pour choisir le bon outil. Si vous voulez simplement savoir quelle recette cuisiner avec vos restes, Flash suffira amplement et répondra quasi instantanément. Si vous êtes un ingénieur qui doit auditer un code critique ou un analyste financier qui doit modéliser des risques complexes, 3.1 Pro est le bon choix pour sa précision et sa profondeur. Enfin, si vous êtes un chercheur en physique quantique tentant de résoudre une équation nouvelle, Deep Think sera nécessaire, malgré son coût et sa lenteur. Cette segmentation permet à Google de proposer une IA adaptée à chaque besoin, tout en gardant 3.1 Pro comme l'étendard standard de l'industrie.

Deep Think : quand le raisonnement devient scientifique

Gemini 3 Deep Think est le vaisseau amiral de la flotte Google en matière de raisonnement. Ce mode ne se contente pas de réfléchir un peu plus longtemps ; il utilise des cycles de raisonnement itératifs complexes, explorant plusieurs hypothèses simultanément, se remettant en question, et vérifiant ses propres déductions. C'est ce que l'on appelle souvent le « Chain of Thought » poussé à son paroxysme. Sur le benchmark ARC-AGI-2, Deep Think atteint des scores vertigineux d'environ 85 %, surpassant même 3.1 Pro. Mais cette puissance a un prix : celui du temps de calcul et de l'argent.

Disponible uniquement pour les abonnés Google AI Ultra, Deep Think est pensé pour la science, la recherche fondamentale et l'ingénierie de pointe. Il peut servir d'assistant pour découvrir de nouveaux médicaments, simuler des réactions chimiques ou élaborer des preuves mathématiques complexes. Pour le grand public ou même le développeur moyen, l'attente et le coût nécessaires pour faire tourner Deep Think ne sont pas justifiés. C'est un outil d'expert pour des problèmes d'expert. 3.1 Pro, avec ses 77,1 %, offre déjà un raisonnement qui dépasse largement les besoins de 99 % des cas d'usage actuels, sans les inconvénients de lourdeur de Deep Think.

Flash : le doctorat bon marché

À l'autre bout du spectre, Gemini 3 Flash est le modèle que la plupart des gens utiliseront sans même le savoir, car il est le réglage par défaut de l'application. Pourtant, ne le sous-estimez pas. Google affirme que Flash offre un « raisonnement de niveau doctorat », comparable à celui des modèles plus grands comme GPT-4, mais avec une rapidité d'exécution fulgurante. C'est le modèle optimisé pour le coût et la latence. Il a également bénéficié d'un bond en avant dans la compréhension multimodale, ce qui le rend très compétent pour analyser des images, des fichiers audio ou des vidéos rapidement.

Pour les usages quotidiens — résumer un email, générer une description pour une photo Instagram, ou trouver une information rapide sur le web — Flash est parfaitement adapté et offre une expérience utilisateur fluide, sans latence perceptible. Pourquoi payer cher et attendre plus longtemps avec 3.1 Pro pour une tâche simple ? La différenciation est claire : Flash pour le volume et la vitesse, 3.1 Pro pour la complexité et la précision. C'est cette stratégie de gamme complète qui permet à Google de capter tous les segments du marché, du grand public aux laboratoires de recherche.

Sécurité et garanties : ce que Google a vérifié avant de lancer

Dans la course à la performance, la sécurité est souvent le parent pauvre. Pourtant, Google a mis les petits plats dans les grands avec Gemini 3.1 Pro sur ce sujet. Le modèle a passé avec succès les évaluations rigoureuses du « Frontier Safety Framework » (FSF), le protocole interne de Google pour évaluer les risques des modèles avancés. L'objectif était de s'assurer que le gain de raisonnement ne se traduise pas par une capacité accrue à causer du tort. Les résultats sont rassurants : le modèle reste sous les seuils d'alerte pour toutes les catégories critiques, notamment CBRN (chimique, biologique, radiologique, nucléaire), la manipulation nuisible, la R&D en machine learning autonome, le « misalignment » (désalignement des objectifs) et les attaques cybernétiques.

Mais ce qui est peut-être le plus remarquable, c'est que Google affirme que 3.1 Pro surpasse Gemini 3 Pro en matière de sécurité et de tonalité, tout en maintenant un faible taux de refus. C'est l'équation gagnante de l'IA moderne : une machine qui est sûre, mais qui n'est pas paralysée par la prudence. Les utilisateurs détestent quand une IA refuse de répondre à une question légitime par excès de « woke-ism » ou de filtres mal calibrés. En réussissant à mieux comprendre le contexte et l'intention de l'utilisateur, Gemini 3.1 Pro évite les refus injustifiés tout en bloquant réellement les requêtes dangereuses. C'est un argument de confiance essentiel pour les entreprises qui hésitent à adopter ces technologies.

Les cinq catégories de risque testées

Le Frontier Safety Framework se concentre sur cinq domaines clés qui représentent les risques les plus sérieux posés par les super-intelligences émergentes. Premièrement, le CBRN : il s'agit de vérifier que le modèle ne peut pas servir de guide facilitant la création d'armes de destruction massive ou de virus chimiques. Deuxièmement, la manipulation nuisible : la capacité de l'IA à générer de la désinformation ou à influencer les gens de manière néfaste (politique, sociale). Troisièmement, la R&D en machine learning : s'assurer que l'IA ne peut pas s'améliorer elle-même de manière autonome pour contourner les garde-fous.

Quatrièmement, le misalignment : le risque que l'IA poursuive des objectifs déviants, interprétant littéralement une commande humaine de manière catastrophique (le fameux problème du « génie du mal »En matière de cybersécurité, l'analyse s'est penchée sur la capacité du système à créer des exploits ou du code malveillant. Après avoir été testé sur l'ensemble de ces cinq domaines, Gemini 3.1 Pro les a tous réussis, prouvant ainsi qu'il présente un niveau de sécurité suffisant pour être proposé au grand public. Bien entendu,« sûr » ne signifie jamais « sans risque », mais cela indique que Google a mis en place des barrières techniques solides et a entraîné le modèle pour refuser explicitement de participer à ces activités illicites ou dangereuses.

Moins de refus, plus de sécurité : l'équilibre gagnante

L'un des problèmes récurrents avec les modèles d'IA récents est la fréquence des « refus » (refusals). Trop souvent, les IA sont entraînées à être si prudentes qu'elles refusent de répondre à des questions inoffensives, un phénomène frustrant qui nuit à la productivité. Google affirme avoir réussi un tour de force avec 3.1 Pro : diminuer ce taux de refus injustifié tout en augmentant la sécurité réelle. Comment ? Grâce à l'amélioration du raisonnement justement. En comprenant mieux le contexte et la nuance, l'IA est capable de distinguer une demande malveillante d'une demande légitime qui pourrait sembler suspecte prise isolément.

Par exemple, une demande sur les « toxines » dans un contexte de roman policier ne sera plus bloquée, alors que la même demande dans un contexte technique de synthèse sera interceptée. Cette nuance est cruciale pour l'adoption en entreprise. Une IA qui refuse constamment aux développeurs de lire ou d'écrire du code par peur qu'il soit malveillant est inutilisable. En affinant cette compréhension, Gemini 3.1 Pro se positionne comme un assistant de confiance, fiable mais pas inhibé. C'est un pas de plus vers une IA qui coopère véritablement avec l'humain plutôt que de lui mettre des bâtons dans les roues à chaque tournant.

Conclusion : Google reprend la main, mais pour combien de temps ?

L'histoire de Gemini 3.1 Pro est celle d'une reprise en main spectaculaire par Google dans la guerre de l'IA. En à peine trois mois, l'entreprise a transformé un modèle performant mais moyen (Gemini 3 Pro) en leader incontesté du raisonnement abstrait avec un score ARC-AGI-2 bondissant de 40 % à 77,1 %. Couplé à un positionnement prix/performance imbattable à 2 dollars le million de tokens et à une fenêtre de contexte gigantesque, ce modèle devient la référence technique et économique pour 2026. Les retours terrain de géants comme JetBrains et Databricks confirment que ce n'est pas juste du marketing, mais une véritable évolution de l'état de l'art accessible dès maintenant.

L'avenir semble sourire à Google, notamment avec l'intégration de sa technologie dans l'écosystème Apple pour améliorer Siri, un signal fort d'adoption massive à venir chez le grand public. Pourtant, dans le monde effréné de la tech, la domination est éphémère. Si Google a réussi ce doublement de performance en trois mois, qui dit qu'OpenAI, Anthropic ou une nouvelle étoile montante ne fera pas de même d'ici l'été ? Une chose est sûre : avec Gemini 3.1 Pro, Google a envoyé un message sans équivoque à ses concurrents et aux utilisateurs. La course à l'intelligence ne fait que commencer, et elle vient d'accélérer brutalement. Pour les consommateurs de technologie, c'est une excellente nouvelle, promettant des outils toujours plus intelligents pour mieux nous assister dans nos tâches complexes.